Γιατί η επόμενη μέρα της Τεχνητής Νοημοσύνης μπορεί να μην έχει καμία σχέση με τις παραδοσιακές κάρτες γραφικών

- 08/01/2026, 13:30

- SHARE

-

Η Nvidia επενδύει 20 δισ. δολάρια στη Groq, δείχνοντας ότι οι κλασικές GPU δεν αρκούν πλέον για το μέλλον της Τεχνητής Νοημοσύνης.

-

Η χρήση της AI στην καθημερινότητα (απαντήσεις, εικόνες, συνομιλίες) γίνεται πιο σημαντική από την εκπαίδευσή της, απαιτώντας πιο γρήγορα και οικονομικά τσιπ.

-

Τα κέντρα δεδομένων AI αλλάζουν μορφή, συνδυάζοντας διαφορετικά είδη επεξεργαστών για καλύτερη ταχύτητα, χαμηλότερη κατανάλωση και μικρότερο κόστος.

Για χρόνια, η άνοδος της Nvidia ήταν συνώνυμη με μία ιδέα: οι κάρτες γραφικών (GPU) είναι η μηχανή της τεχνητής νοημοσύνης. Όμως η συμφωνία των 20 δισεκατομμυρίων δολαρίων της Nvidia με τη Groq αποτελεί παραδοχή ότι η επόμενη φάση της Τεχνητής Νοημοσύνης δεν θα κερδηθεί μόνο από τις GPU.

Η Groq κατασκευάζει έναν πολύ διαφορετικό τύπο τσιπ AI, που ονομάζεται Language Processing Unit (LPU). Για να καταλάβει κανείς γιατί η Nvidia ξόδεψε τόσα πολλά χρήματα, και γιατί δεν κατασκεύασε απλώς αυτή την τεχνολογία μόνη της, πρέπει να δει προς τα πού κατευθύνονται τα φορτία εργασίας της AI. Η βιομηχανία μετακινείται από την εκπαίδευση μοντέλων στη λειτουργία τους στον πραγματικό κόσμο. Αυτή η μετατόπιση έχει όνομα: inference (συμπερασματοποίηση).

Το inference είναι αυτό που συμβαίνει μετά την εκπαίδευση ενός μοντέλου, όταν απαντά σε ερωτήσεις, δημιουργεί εικόνες ή συνομιλεί με τους χρήστες. Γίνεται το κυρίαρχο έργο στην υπολογιστική AI και, σύμφωνα με εκτιμήσεις που συνέλεξαν πρόσφατα αναλυτές της RBC Capital, θα μπορούσε στο μέλλον να ξεπεράσει κατά πολύ την αγορά της εκπαίδευσης.

Αυτό έχει σημασία επειδή το inference έχει πολύ διαφορετικές απαιτήσεις από την εκπαίδευση. Η εκπαίδευση μοιάζει με την κατασκευή ενός εγκεφάλου: απαιτεί τεράστια ακατέργαστη υπολογιστική ισχύ και ευελιξία. Το inference μοιάζει περισσότερο με τη χρήση αυτού του εγκεφάλου σε πραγματικό χρόνο. Η ταχύτητα, η συνέπεια, η ενεργειακή απόδοση και το κόστος ανά απάντηση γίνονται ξαφνικά πολύ πιο σημαντικά από τη σκέτη ισχύ.

Εδώ μπαίνει στο παιχνίδι η Groq. Ιδρυμένη από πρώην μηχανικούς της Google, η Groq έχτισε τη δραστηριότητά της γύρω από τσιπ αποκλειστικά για inference. Οι LPU της είναι σχεδιασμένες λιγότερο σαν εργοστάσια γενικής χρήσης και περισσότερο σαν γραμμές συναρμολόγησης ακριβείας. Κάθε λειτουργία είναι προγραμματισμένη εκ των προτέρων, εκτελείται με σταθερή σειρά και επαναλαμβάνεται τέλεια κάθε φορά. Αυτή η ακαμψία είναι αδυναμία για την εκπαίδευση, αλλά πλεονέκτημα για το inference, όπου η προβλεψιμότητα μεταφράζεται σε χαμηλότερη καθυστέρηση και λιγότερη σπατάλη ενέργειας.

Αντίθετα, οι GPU της Nvidia (Graphics Processing Units) είναι σχεδιασμένες για ευελιξία. Βασίζονται σε μηχανισμούς χρονοπρογραμματισμού και μεγάλες δεξαμενές εξωτερικής μνήμης για να διαχειρίζονται πολλά διαφορετικά φορτία εργασίας. Αυτή η ευελιξία είναι ο λόγος που οι GPU κυριάρχησαν στην αγορά της εκπαίδευσης, αλλά δημιουργεί και επιβάρυνση που επιβραδύνει το inference. Καθώς τα προϊόντα AI ωριμάζουν και σταθεροποιούνται, αυτός ο συμβιβασμός γίνεται όλο και πιο δύσκολο να δικαιολογηθεί.

Τα οικονομικά του inference

Όπως αναφέρει σε άρθρο του το Business Insider, τα οικονομικά είναι δελεαστικά. Το inference είναι το σημείο όπου τα προϊόντα AI βγάζουν χρήματα. Είναι η φάση που αποδεικνύει αν τα εκατοντάδες δισεκατομμύρια δολάρια που δαπανήθηκαν σε data centers θα αποδώσουν ποτέ.

Το σημαντικό είναι ότι η Nvidia δεν ποντάρει σε έναν μόνο νικητή. Οι GPU θα συνεχίσουν να αναλαμβάνουν την εκπαίδευση και τα ευέλικτα φορτία εργασίας. Τα εξειδικευμένα τσιπ, όπως της Groq, θα χειρίζονται το γρήγορο, σε πραγματικό χρόνο inference. Το πλεονέκτημα της Nvidia βρίσκεται στο ότι κατέχει τον συνδετικό ιστό — το λογισμικό, τη δικτύωση και το οικοσύστημα προγραμματιστών που επιτρέπουν σε αυτά τα στοιχεία να συνεργάζονται.

Πόσο «ανίκητη» είναι η Nvidia;

21/12/2025«Τα AI data centers μετατρέπονται σε υβριδικά περιβάλλοντα όπου GPU και προσαρμοσμένα ASIC λειτουργούν δίπλα-δίπλα, το καθένα βελτιστοποιημένο για διαφορετικούς τύπους φορτίου εργασίας», έγραψαν αναλυτές της RBC σε πρόσφατο σημείωμα, αναφερόμενοι σε ολοκληρωμένα κυκλώματα ειδικού σκοπού όπως οι LPU της Groq.

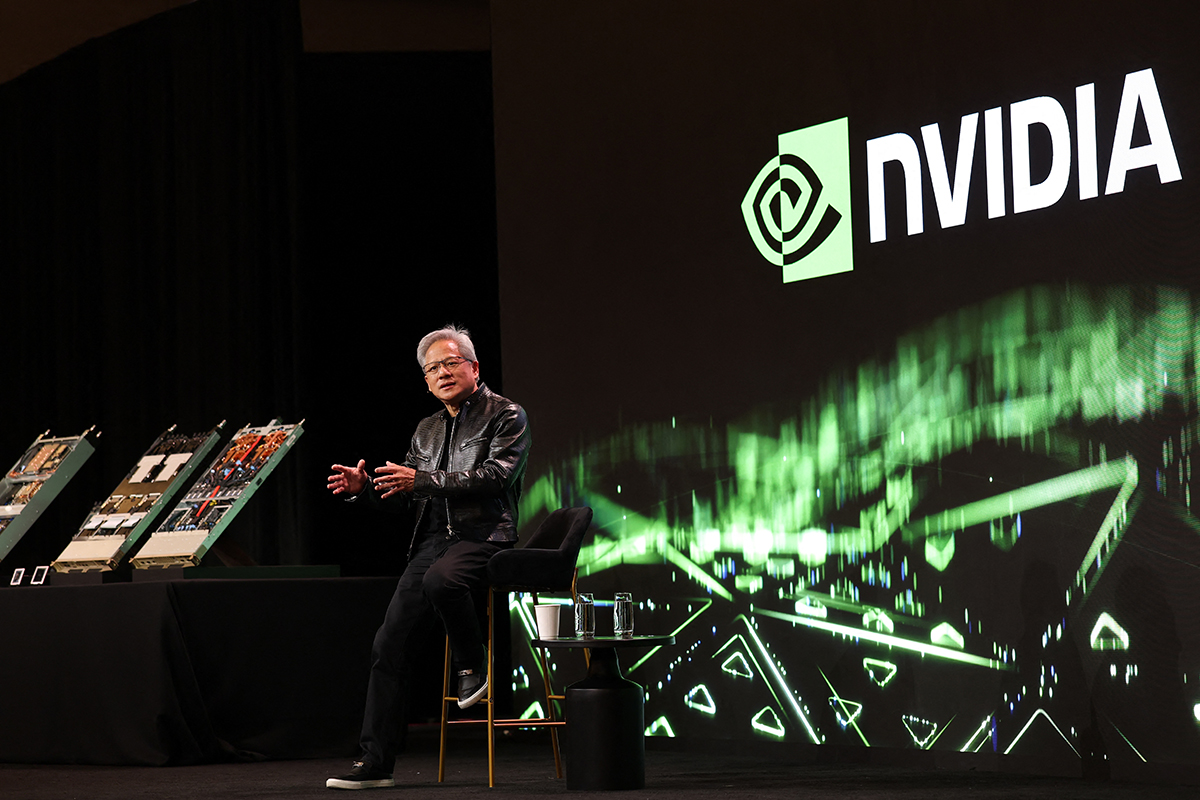

Ορισμένοι ανταγωνιστές υποστηρίζουν ότι η συμφωνία αποδεικνύει πως οι GPU δεν είναι κατάλληλες για inference υψηλής ταχύτητας. Άλλοι τη βλέπουν ως επιβεβαίωση ενός πιο κατακερματισμένου μέλλοντος, όπου διαφορετικά τσιπ εξυπηρετούν διαφορετικές ανάγκες. Ο CEO της Nvidia Jensen Huang φαίνεται ξεκάθαρα να ανήκει στη δεύτερη άποψη. Με την αδειοδότηση της τεχνολογίας της Groq και την ένταξη της ομάδας της «εντός των τειχών», η Nvidia διασφαλίζει ότι μπορεί να προσφέρει στους πελάτες τόσο τα φτυάρια όσο και τις γραμμές συναρμολόγησης της AI.